| |

|

|

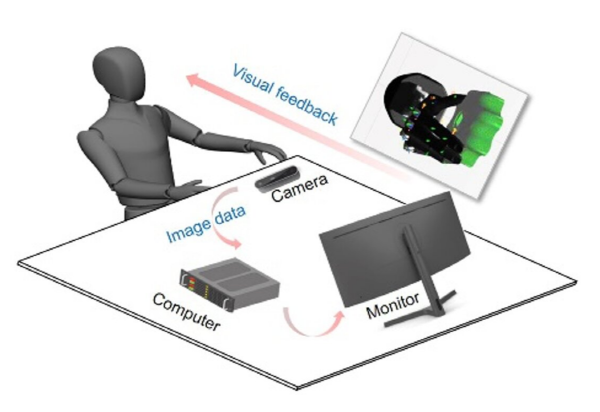

| ▲사람의 시연 동작을 보고 학습하는 로봇 핸드 기술 개념도(이미지=함부르크대) |

독일 함부르크대 연구팀이 사람 손동작을 원격 학습할 수 있는 로봇핸드 조작 기술을 개발했다고 테크엑스플로어가 지난 11일(현지 시각) 보도했다.

함부르크대 연구팀은 5개의 손가락을 갖고 있는 로봇 핸드를 원격 조작하는 방식으로, 사람의 손 동작을 학습하고 물체를 조작할 수 있는 기술을 개발하고, 연구 성과를 ‘신경 네트워크 및 학습 시스템에 관한 IEEE 트랜잭션’(IEEE Transactions on Neural Networks and Learning Systems)에 소개했다.

이번 연구를 주도적으로 수행한 차오 정(Chao Zeng) 박사는 “이번 연구의 원래 아이디어는 사람의 손 조작 기술을 복수의 손가락을 갖고 있는 로봇 핸드에 전달할 수 있는 원격 조작시스템을 개발하는 것이었다”고 말했다. 연구팀은 광학 마커가 부착되어 있는 장갑을 착용하지 않고도, 로봇 핸드가 사람의 손동작을 학습할 수 있도록 했다.

연구팀은 로봇이 사람의 시연 장면을 관찰함으로써 능숙한 핸드 조작 기술을 습득하는 것을 원했다. 인간 사용자에게 광학 마커가 있는 장갑을 착용하도록 강요하는게 아니라 신체적 제한 없이도 자유롭게 손가락을 움직일 수 있도록 했다. 연구팀은 카메라를 사용해 인간 사용자의 손 자세 이미지를 캡처했다. 이를 통해 궁극적으로 유망한 결과를 얻을 수 있었다.

연구팀은 로봇이 물체를 잡거나 잡는 힘을 제어하는 것이 더욱 순응적인 조작 기술을 얻는 데 도움이 된다는 점을 확인했다.

연구진이 개발한 접근법의 첫번째 단계는 인간 사용자의 손동작 자세를 포착하고 DNN을 사용해 로봇 관절의 각도에 매핑하는 것이다. 두 번째 단계는 기준 각도가 주어질 때마다 원하는 힘 명령을 예측할 수 있는 힘 제어전략(force control strategy)을 설계하는 것이다.

연구원들은 섀도우 핸드(Shadow Hand)사의 로봇 핸드를 활용해 시뮬레이션과 실제 환경에서 테스트를 진행하고 이번에 개발한 접근 방식을 평가했다. |